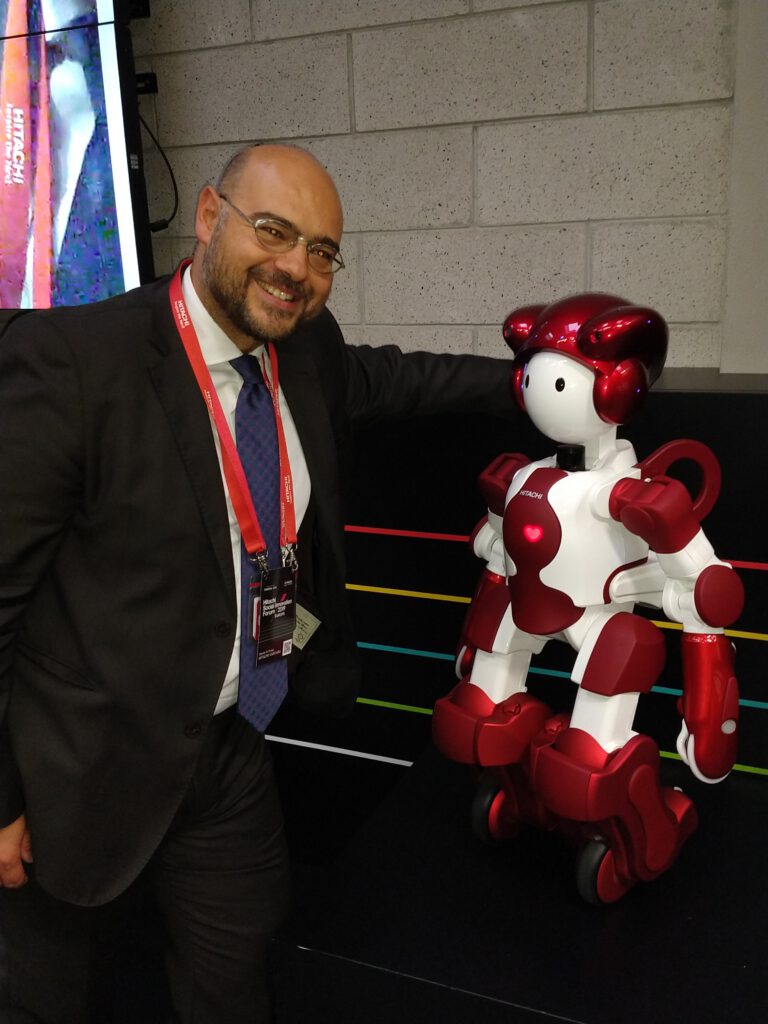

Devrim Di Finizio (Hitachi) tra i protagonisti del Data Management Summit

Stiamo rivelando giorno dopo giorno tutti i professionisti che parteciperanno con le loro presentazioni all’evento più importante del Data Management. Per la prima volta un forum cerca di concentrarsi sul Data Management nella sua interezza, dalla governance, attraverso la sicurezza, il cloud, il machine learning, la virtualizzazione dei dati e molto altro. Oggi vi presentiamo Devrim Di Finizio, BU Software, Italy Lead di Hitachi.

Parlaci un po’ di te e del tuo background professionale (usare la prima persona)

Ho studiato Statistica quindi la mia passione sui dati è della prima ora, applico l’approccio data driven e data evidence based in tutto, non solo al lavoro, quindi sono davvero un data-maniac. Ho speso una dozzina d’anni nella consulenza, lavorando per importanti firme come Ernst&Young, Cap Gemini, Bain & Co e poi un’altra dozzina d’anni in tech company come SPSS, HP, IBM e ora Hitachi. Sono curioso e dedito ai miei Clienti, dai quali ho imparato tutto quello che conosco, lavoro insieme a loro nell’individuare e definire soluzioni per la trasformazione digitale data driven e IoT, migliorando i processi aziendali con applicazioni che valorizzano i (big) data con advanced analytics e machine learning.

Quali sono le vostre sfide, cosa vi piace fare con i dati?

La sfida che la maggior parte delle Aziende deve affrontare è come gestire e ottenere l’accesso al patrimonio informativo che si forma dalla commistione di innumerevoli sorgenti. Un nome appropriato per tutti questi dati che non possono essere visualizzati, utilizzati o gestiti, è dark data.

Una varietà di contesti rendono questo problema particolarmente centrale:

- I volumi di dati stanno esplodendo, aumentando la quantità di dati che devono essere compresi o rimanere dark data. Secondo IDC, viene analizzato solo il 2,5% circa di tutti i dati; il resto è perso e il suo valore potenziale inutilizzato.

- L’adozione del cloud pubblico ha notevolmente ampliato le posizioni in cui risiedono i dati e ha allentato il controllo sulla creazione e la gestione dei dati. Gartner® prevede che “Entro il 2022, i servizi cloud pubblici saranno essenziali per il 90% dell’innovazione dei dati e dell’analisi”.[1] Secondo ESG, l’81% delle aziende utilizza più di un provider di infrastrutture cloud, sia per IaaS che per PaaS. Ed il 51% ne usa tre o più.

- L’utilizzo self-service dei dati deve essere supportato per renderne effettivo l’utilizzo da parte di tutto il tea,. Se i dati sono dark, di fatto non esistono e non vengono sfruttati dagli utenti. Se è difficile da trovare, la produttività precipita. Un rapporto di 451 Research sui DataOps ha rivelato che il 25% di tutti i chief data officer (CDO) con più di 2 PB di dati afferma che il personale trascorre oltre il 50% del tempo per trovare e per accedere ai dati.

Il tema è affrontato brillantemente nel nostro blog: https://www.hitachivantara.com/blog/how-dataops-shines-light-on-growing-dark-data-problem/

Pensi che le aziende abbiano la cultura giusta per gestire i dati in modo corretto?

Hitachi Vantara crede che il Data Ops rappresenti il futuro della gestione dei dati. DataOps, definito come evoluzione delle pratiche di DevOps applicate alle sfide dei dati aziendali, risolve molti dei problemi che le aziende devono affrontare per sfruttare la potenza dei dati espandendone l’utilizzo in ogni contesto organizzativo.

Man mano che il Data Ops viene adottato in modo più pervasivo è chiara la necessità di adattarsi alle esigenze univoche di un’organizzazione. In Hitachi Vantara crediamo che DataOps debba evolversi per affrontare problemi come la governance dei dati, la sicurezza e il controllo degli accessi in modo automatizzato e scalabile. Parte dell’evoluzione sarà culturale ed è di questo che vogliamo parlare in questo articolo. Riteniamo che le seguenti dimensioni culturali siano cruciali per l’adozione di successo di DataOps:

- Collaborazione

- Automazione e mindset incentrato sui metadati

- Dati come risorsa condivisa

- Design thinking end-to-end

- Rimozione dei data silos

- Processo decisionale push-down

C’è una interessante whitepaper che Hitachi ha messo a disposizione dei suoi Clienti che consiglio di leggere: https://www.hitachivantara.com/en-us/pdf/white-paper/cultural-impact-of-dataops-whitepaper.pdf

Quali sono le sfide più importanti per i CIO, CDO, CTO nel 2022?

Le sfide chiave per i CIO nel 2022 sono:

- Costi di backup: costi proibitivi per strategie di constant backup

- Posizionamento dei dati: dove posizione i miei dati ottimizzando i costi rispetto alla frequenza di utilizzo

- Conformità alle normative: potrei non conservare tutti i dati richiesti dalle norme di conformità

- Duplicazione massiccia: la metà di tutti i dati aziendali è duplicata

- Complessità del cloud: quali dati trasferire nel cloud? Come posso garantire la loro protezione?

Le sfide chiave per i CDO nel 2022 sono:

- Proliferazione dei dati: tipi di dati differenti da molteplici fonti

- Passare al cloud è difficile: più opzioni di processing, realtà ibride e multi-cloud complicano l’ecosistema

- Divario di competenze: è difficile trovare persone con competenze recenti nella gestione dei dati.

- Dark Data: dove sono i rischi e le opportunità in tutti i dati che stiamo raccogliendo?

- Sovraccarico normativo: come possiamo tenere il passo con normative sempre più complesse e rigorose?

Abbiamo la fortuna di averti alla tavola rotonda Data Fabric & Data Valuation un argomento interessante… cosa ne pensi? Dove andrá il tuo contributo?

Nell’ultimo decennio, le organizzazioni hanno sempre più faticato a gestire in modo efficace i dati in crescita, a ridurre al minimo i silos e a raccogliere informazioni utili. Se integrato correttamente, il data fabric ha il potere di consentire alle aziende di accedere ai propri dati e affrontare tali sfide. Il data fabric è un’architettura moderna di gestione dei dati che orchestra in modo intelligente sorgenti dati disparate. “Intelligente” è essenziale in questo contesto. I data fabric non si limitano a riunire le sorgenti dati; è un framework per farlo in modo contestuale, sicuro ed integrato che abilita un approccio self-service e supporta un’ampia varietà di applicazioni, carichi di lavoro operativi, analisi e casi d’uso. Idealmente, le organizzazioni vorrebbero abilitare processi decisionali più intelligenti che siano in grado di:

- Distribuire le applicazioni in pochi giorni, non mesi o anni, mantenere un vantaggio competitivo e permettendo di sfruttare al meglio le opportunità

- Eliminare i silos di dati che isolano le informazioni cruciali all’interno di un data center o nel cloud o in un’infrastruttura multicloud.

- Combina dati non strutturati con dati strutturati per creare analisi e approfondimenti più completi.

- Migliorare la collaborazione tra IT e organizzazioni aziendali.

- Ridurre la duplicazione dei dati per garantire una verità coerente e affidabile ai dati utilizzati nell’intera azienda.

Fin dall’inizio avete sostenuto l’evento Perché?

Come ho detto, il confronto è una continua fonte di ispirazione e apprendimento. Crediamo di poter dare valore promuovendo Eventi e dando un contributo di contenuto ma anche e soprattutto imparare e trovare nuovi stimoli.